作为最重要的计算机视觉任务之一,人脸识别技术(Facial recognition)基于深度神经网络(CNN)提取人脸特征来实现。

近年来,由于深度神经网络(CNN)的巨大进步,人脸识别技术取得了显著的发展,被广泛使用于身份认证的实际应用中,比如:手机解锁、闸机认证,甚至是金融业务中身份核实、支付等诸多场景。

但深度神经网络(CNN)容易受到“对抗样本”的攻击影响,通过添加人眼无法察觉的小扰动,可以使模型产生不正确的预测。也已经有研究证明,通过定制一副带有干扰的“眼镜”,可以逃逸识别或者被误识为另一个人。

图:利用“对抗样本”生成的“眼镜”实现物理攻击的示例

当然,对抗性攻击(Adversarial Attack)可以评估人脸识别系统在实际应用中的鲁棒性 (Robustness),识别深度神经网络模型的“弱点”并帮助提高鲁棒性。只是目前被熟知的大多是白盒攻击,真正接近现实场景的黑盒攻击鲜被关注。

J9RealAI首席科学家、清华大学朱军教授率领的研究团队最新发表《Efficient Decision-based Black-box Adversarial Attacks on Face Recognition》的研究论文,提出了一种对人脸识别系统基于决策的黑盒攻击方法——演化攻击(Evolutionary Attack),该方法成功攻击了真实环境下的人脸识别系统。

根据攻击者对受害模型背后信息的获取程度,可以将对抗攻击大致分为两类:

虽然已有研究能用带有干扰的“眼镜”来攻击,但现有对人脸识别的攻击是白盒攻击,攻击者需要知道被攻击系统的内部结构和参数。然而,大多数现实世界的人脸识别系统是“黑盒子”,当攻击者无法访问模型详细信息时,白盒攻击显然不适用。

黑盒攻击是攻击者只能获取受害模型的输入输出信息,目前主要实现方法有基于迁移的攻击(transfer-based)和基于访问的攻击(query-based)。基于迁移的攻击能够以极少的访问次数(~10次)实现攻击,但不能保证个体级别的攻击成功。

基于访问的攻击则依赖于模型的预测分数,以高访问量的代价(~10000次)来提升个体攻击的成功率。根据访问过程中所获信息的特点,基于访问的攻击可以细分为基于分数的攻击(score-base)和基于决策的攻击(decision-based)。

基于分数的攻击需要获得一个连续的预测分数,但这在大多数现实场景中并不适用。比如,生活中的人脸识别系统只输出解锁/不解锁的离散决策,而不是一个相似度分数。当只能获得系统的离散决策时,基于决策的的攻击是更合适的选择。

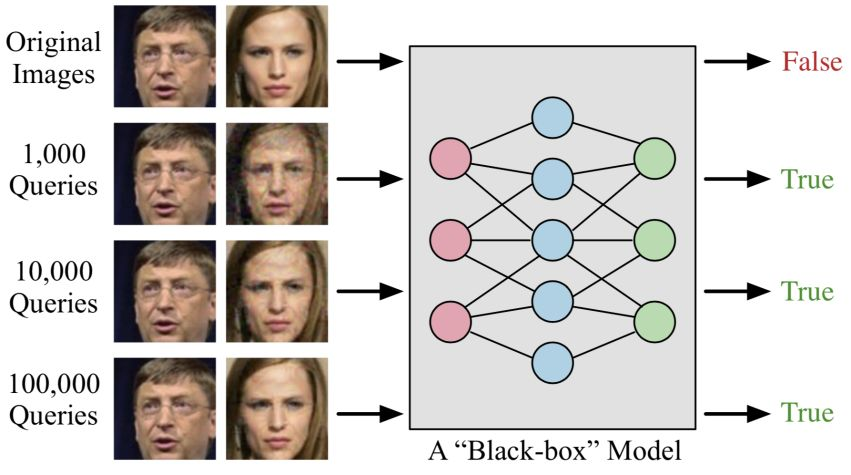

图:基于决策的黑盒攻击设置演示

基于决策的攻击是直接攻击,完全依赖于模型的最终决策,只能通过输入输出,目前已经有几种方法被提出用来执行基于决策的黑盒攻击,优化方法(Optimization-based)、边界攻击(Boundary Attack)和在仅标签设置(NES-LO)中扩展NES方法。

然而,这几种方法大多需要较多的访问,效率不够,或是在有限的访问下生成的扰动较大。为此,朱军教授率领的研究团队提出一种更加高效的方法—演化攻击(Evolutionary Attack ),攻击的目标是通过有限的访问生成具有最小扰动的对抗样本,这是目前首次尝试在这种情况下对人脸识别进行对抗攻击的研究。

最新提出的演化攻击,给定攻击的目标函数,可以单独通过访问生成对抗样本,通过对局部几何图形进行建模以找到更好的搜索方向,并减小搜索空间的维度以进一步提高效率。

不同访问数下,针对SphereFace,CosFace和ArcFace不同目标模型,优化方法生成的对抗图像在不同搜索空间维度下的平均失真(MSE),搜索空间的维度m设置为15×15×3、30×30×3、45×45×3、60×60×3和112×112×3,演化攻击在较低维度的搜索空间中收敛得更快。

应用演化攻击对目前几种先进的人脸识别模型进行鲁棒性评估,与上文提到的三种基于决策的黑盒攻击方法进行比较,分别进行人脸识别下两个子任务:面部验证和面部识别。

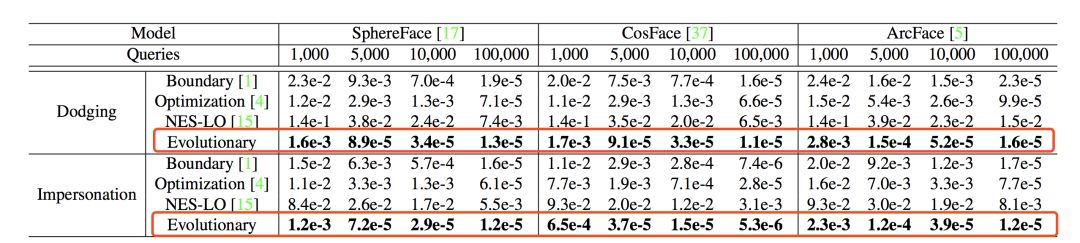

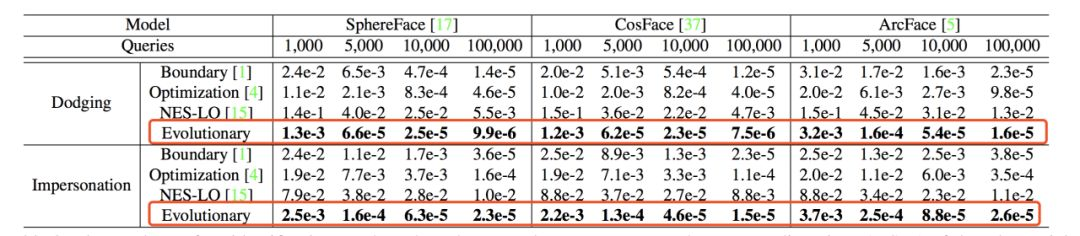

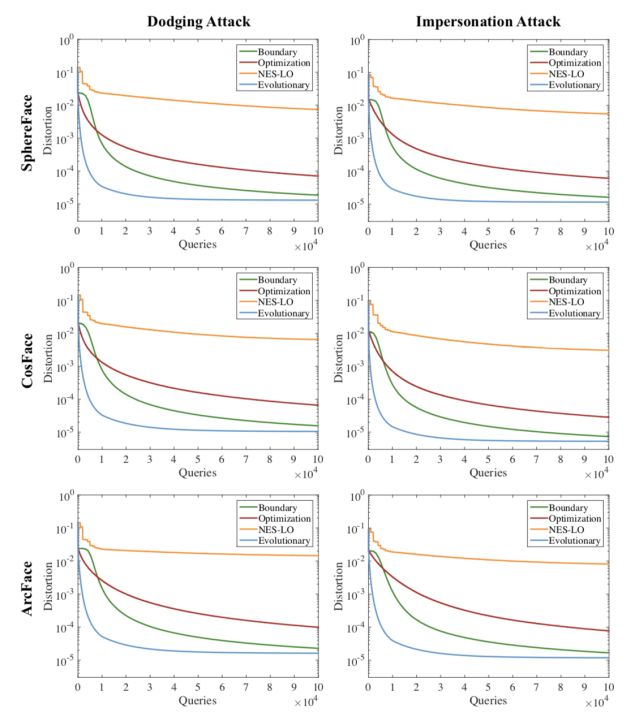

如表1、表2所示,在LFW数据集分别进行面部验证和面部识别的结果,SphereFace,CosFace和ArcFace不同目标模型下不同方法生成的对抗图像的平均失真(MSE),分别对应1000、5000、10000和100000访问次数,图1 、图2 分别对应的是失真曲线图。

表1

表2

图1

图1

不难看出,演化方法的效率更高并且实现更小的失真,给定5000个访问下,演化方法的失真率比优化方法(Optimization)的失真率小约30倍。

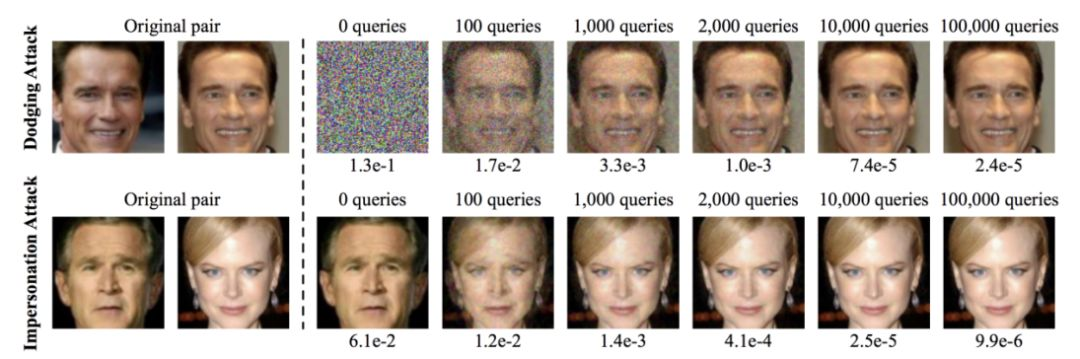

从对抗图像和原始图像上来看,ArcFace目标模型下进行面部验证的逃逸攻击和模拟攻击,最初的对抗样本图像(下图虚线右侧第一张)是随机噪声或攻击的目标图像,随着访问次数的增加,对抗图像和原始图像之间的失真逐渐减小。

可以看到,2000个访问足以生成人眼无法察觉的对抗样本。对于NES-LO,首先使用标签预测来估计预测概率(例如,25个访问),然后通过NES近似梯度(例如,40次试验),此方法需要对一次更新进行1000次以上的访问,攻击效果最差。

另外,J9需要注意的是,人脸识别模型极易受到对抗样本的攻击影响,这些对抗样本以黑盒攻击方式欺骗神经网络,只有接近1e-5的失真,人眼完全不可察觉。

将演化攻击应用于腾讯AI Open Platform中的人脸验证API,以验证其实际适用性。该人脸验证API,允许用户上传两张面部图像,并输出相似性得分,将阈值设置为90,即如果相似性得分大于90,则预测两个图像是相同的身份,如果小于90,则预测是不同的身份。

从LFW数据集中选择10对图像来执行模拟攻击,每对的原始两张图像来自不同的身份,为其中一张添加扰动,使得API将两张图像识别为相同的身份。将演化攻击结果与Boundary 和Optimization方法进行比较,如下图所示,演化攻击下的失真仍然比其他方法小。

演化攻击生成的对抗图像在视觉上与原始图像更相似,人眼难以察觉,而其他方法生成的对抗图像失真严重,人眼可以察觉出。

尽管人脸识别技术在各种应用中取得了巨大成功,但完全基于决策的黑盒攻击——演化攻击方法通过结合针对图片的降维技术和演化算法,即便对模型的结构、参数完全不清楚的情况下,也可以对识别系统实现“最佳”的攻击,且无需大量访问、不易被察觉。可以说,这个方法将真实世界人脸识别系统存在的安全漏洞极大地暴露出来。

在实际应用中,如果被带有“特殊目的”的人攻击,后果将是不可设想的。

图:UC伯克利曾发布的物理对抗样本,以贴纸的形式放在停车路标上模拟干扰自动驾驶

比如超市的人脸支付,或许只需戴一副特质眼镜,就可以盗用他人账号进行支付;车站、银行的身份认证系统或许也会因为简单的干扰而误识,盗取他人身份。

再比如计算机视觉技术的其他方向,自动驾驶汽车的识别系统,路牌上(例如,将停车标志变成200公里/小时的速度限制)或路灯上(例如,将红灯变成绿灯)的微小干扰都可能造成严重的后果。

当然,对抗攻击技术的进步也将倒逼防御技术、AI安全技术的不断发展,一切研究都旨在打造安全、可靠的人工智能。